装了这款微软官方"外挂",我卸载了电脑里乱七八糟的10个付费软件

1. PowerToys 简介起因是,我在 Windows 上删除某个文件或者文件夹的时候,经常被提示占用。 然后我又不知道被谁占用,想删除除了重启别无他法。 我就寻思,我烦够了,要不我问问 Gemini。然后他就告诉了我这个神器。 我就去官网看了下,看的过程,内心不断地惊呼,😱。太牛了吧。 PowerToys 官方文档 大家可以粗略看一眼。太 6 了。 比如 hosts 管理,我以前还需要下载一个软件 SwitchHosts;比如 OCR,比如那个灯开关,我以前还需要专门下载一个日出日落的工具;比如命令面板,我还下载个 uTools;还有那个高级粘贴…… 太牛了,炸裂。最关键这玩意儿开源的。 PowerToys GitHub 仓库 你说微软,为啥不搞到原生系统里面呢? 比如,查看谁占用了这个文件: 2. 所有功能 功能名称 (中/英) 技术定义 (Technical Definition) 普通人/办公族的”救命”场景 (Lifesaver Scenario) Advanced Paste(高级粘贴) AI 驱动的剪贴板转换工...

Gemini Voyager:让Gemini变好用的最后一块拼图

1. 为什么写这个大家可能会想:Gemini 已经够强了,还需要什么插件?我想说不是的。 先说结论:原生 Gemini 是个顶级模型,但它现在的网页端体验,离”好用的生产力工具”还差得远。 你有没有遇到过这种崩溃瞬间: 长对话聊到后面,滚轮滚到手酸也找不到刚才那段代码在哪。 想引用 AI 的一句话反驳,得复制、粘贴、手动打个 >,烦得想摔键盘。 好不容易调教好的 Prompt,下次换个新对话又要重新打一遍。 网页上聊透了方案,回到 VS Code 里还得像教小学生一样重新给 AI 喂背景。 写到这里你可能会想:忍忍不就过去了?没关系,我以前也忍。直到我发现了 Gemini Voyager。 它不只是修补丁,它是直接给 Gemini 的工作流”升舱”。 2. 长对话的”解药”:时间轴与引用在原生界面里,长对话就是灾难。你就像在一个没有路标的迷宫里,上上下下,找不着北。 Voyager 给出的解法极其直观:右侧时间轴。 它就像视频的进度条,或者书的目录: 每一个点,就是一次对话。 鼠标放上去,能偷看(预览)内容。 点一下,瞬间瞬移过去。 长按,还能加星(插眼),标记高...

春节别再花冤枉钱买封面了!用AI做专属红包,还能顺手赚个过年费(附保姆级教程)

前几天微信公众后发布了我去年的年度报告,在最后给我送了1500个红包封面的权限。我寻思不能浪费啊,AI生成工具已经很成熟了,我就研究了下怎么制作红包封面和发放。微信的红包封面还有了付费功能(只要按照流程申请即可,好像还在灰度测试,大家可以上去看看被灰度到了没有),大家可以趁着春节制作一波,挣一波红包,回回血。小红书貌似有人赚了好几万。 如果大家不太想自己制作,也欢迎滑到最后,领取我制作的红包封面使用! 这是付费封面的界面,就跟表情似的,可以付费买这个红包封面:这是我制作的效果:: 付费封面和普通封面的制作流程是一样的,下面我们说一下正常的红包封面怎么制作。 ok,红包封面制作流程需要要的主要工具: 即梦AI:https://jimeng.jianying.com/ai-tool/home 微信红包封面开放平台:https://cover.weixin.qq.com/ 正常情况下,只要满足以下任一条件,就可以上架微信红包封面: 完成企业认证的微信公众号用户 完成企业认证的微信视频号用户 粉丝数达100个的公众号个人用户 满足以下任一条件的视频号个人用户: 1)粉丝数达100个...

让AI记住你,而非每次都重新认识—我的Obsidian个人助理改造实录

最近我开始习惯使用Obsidian来管理我自己的个人日志,不管是公众号的文章,还是笔记,收藏的文件。最开始的时候,我执行了一次claude code的初始化命令/init,为了让AI更加了解我的Obsidain的内容和结构。当然,在这个过程中,我把自己不希望任何AI阅读的文件夹,全部移出了Obsidian。你们也要注意这种信息安全,比如我自己每天的流水账似的日记(大家也可以尝试下,大概每天花5min,直接语音输入法输入,不管输入是正确还是错误,5min就可以记录完成)。我不希望AI读这些内容,所以我就先移出去,初始化以后,再移回来。 但是后来我就发现,并不能达到让他理解我的程度。也不能很好的成为我的个人助理。 1. 魔改方案所以结合最近使用skill的经验,借鉴了skill这种渐进式加载,或者说按需加载的模式,对claude.md进行了魔改。claude.md中我只保留了最重要的信息,大家如果观察过这个网络请求日志的话,可能会发现,claude.md是当做系统提示词的补充,在每次请求时都加载上的。这个会变相的增加系统提示词的长度,占据我们宝贵的上下文空间。所以我这样进行了魔改, ...

花了半天时间,将元素周期表搞成了一个"可教学"的小工具

花了半天时间,将元素周期表搞成了一个”可教学”的小工具 昨天看到一个作者使用最新的kimi2.5做了一个元素周期表,我觉得很酷,所以我进行了复刻。 公众号文章:https://mp.weixin.qq.com/s/A7VY2fwcnDs2a4Pt2wIeCA然后在原来的基础上,通过Gemini在github上找到了元素的权威数据源,对本地元素周期表的数据进行了整体性的更新。又通过Nist补充了光谱的相关数据。把Deepseek的接口文档给到了它,让他接入了大模型。成品在这里: 欢迎大家使用。如果大家要源码,请私信我。 我就在想啊。个性化的前端(AI实时生成),加上统一的后端接口服务,这事儿离我们是越来越近了。前端在随意定制,后端也能配合着前端的要求灵活调整。你看,以千问、蚂蚁的灵光为代表的这些产品,其实都在往同一个方向走:从以应用为中心(App-centric)向以智能体为中心(Agent-centric)的范式转移。原来我们总说应用就是流量,但未来,智能体才是流量。再往深了看,其实终端才是最终的流量。原来的 APP,可能就回归本质,变成了一个个接口,或者说单纯的工具。在智能...

哈萨比斯谈人工智能的转变,超越了工业时代

哈萨比斯谈人工智能的转变,超越了工业时代Google DeepMind 联合创始人兼首席执行官 Demis Hassabis 在 2026 年世界经济论坛期间,于达沃斯彭博之家与彭博社的 Emily Chang 讨论了人工智能未来的发展,包括基础模型的进展、现实应用和负责任的 AI 开发。 1. 目录 访谈背景 人物背景介绍 对话实录 2. 访谈背景 [!tips]本次访谈发生在 2026 年世界经济论坛达沃斯会议期间,正值 AI 技术快速演进的关键时期。DeepMind 的 Gemini 系列模型展现出强大的竞争力,而关于 AGI(通用人工智能)的实现时间表、AI 对就业市场的影响、以及全球 AI 监管等话题成为业界关注的焦点。 3. 人物背景介绍3.1. 核心对话人物Demis Hassabis(戴米斯·哈萨比斯):Google DeepMind 创始人兼 CEO,2024 年诺贝尔化学奖得主。他是通用人工智能(AGI)领域的领军人物,主导了从 AlphaGo 到 Gemini 的一系列技术跨越,目前负责谷歌全球 AI 的技术研发与战略。 Francine Lacqua(...

遇事不决问AI的含金量:看我如何一句话把Python脚本打包成EXE

给业务人员(比如家里那位)写Python脚本,最头疼的往往不是代码本身,而是交付。 你让人家装Python、配pip、安依赖包,这事儿基本就黄了。最好的交付方式,永远是给对方一个双击就能用的 .exe 文件。 但是,我完全不知道行不行的通,行得通的话,应该怎么做。 遇事不决,可问AI。 于是,我就问AI能不能把python环境,python包统一打包成一个exe应用,直接点击就能使用。 果然可以。 然后我就开始使用trae(字节跳动的AI写代码的软件),来帮我打包。 命令很简单: 使用PyInstaller将当前目录下的python脚本打包为直接点击即可使用,无需配置各种环境的exe应用 ok,一次成功。 既然流程跑通了,这事儿我也不会只做一次,我就寻思得把这次成功的“过程”固化下来,变成可复用的资产。 所以我进一步搞了一个 Skill(技能)。你可以理解为我给AI写了一份“标准作业程序(SOP)”。 只要有具体的操作步骤,就可以搞成skill。 继续使用trae创建: 使用skill-creater,将 `https://github.com/pyinstaller/p...

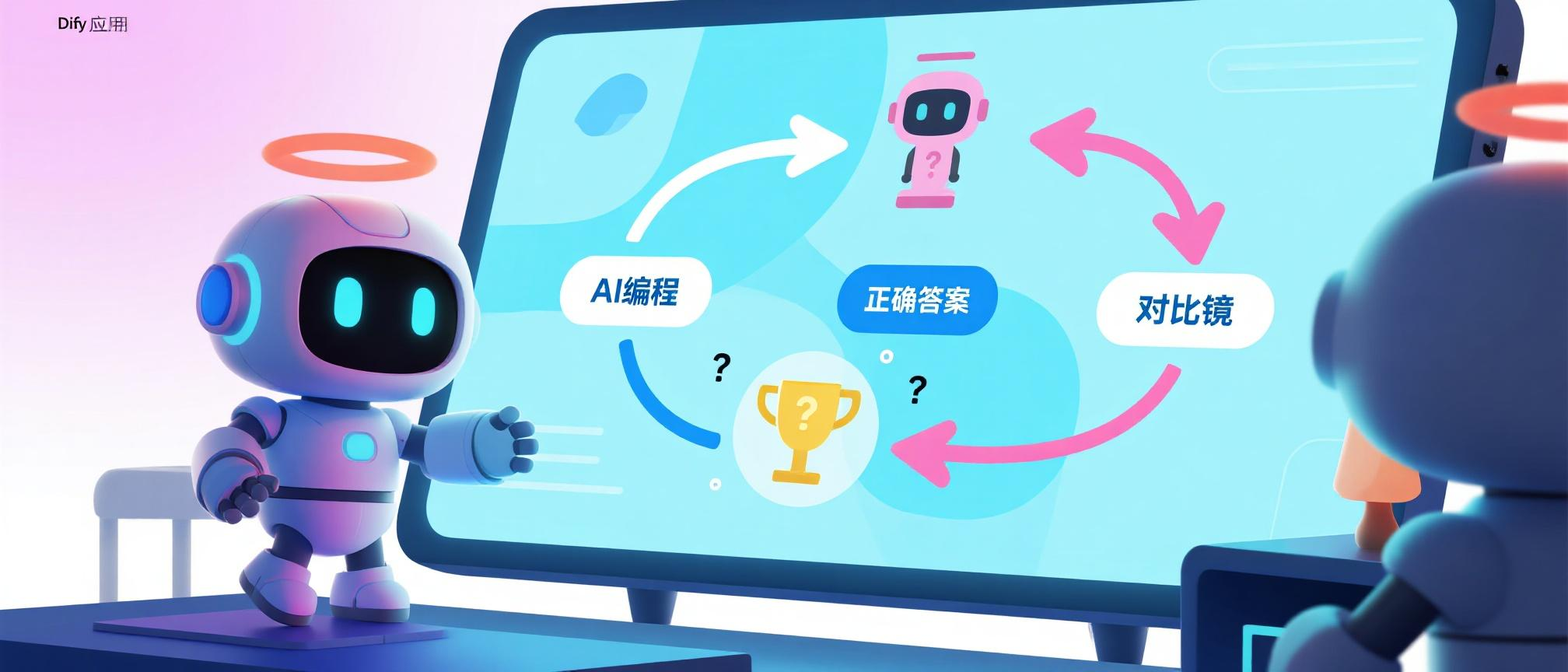

进阶教程:给AI装上"逻辑大脑",打造金融级稳定的多轮对话Agent(Dify实战)

之前,我们讨论过一次怎么样使用dify来构建多轮对话。保姆级教程:手把手教你用Dify实现完美多轮对话(附Chatflow和提示词)这个名字取得还可以,哈哈。但是实际生产使用会存在一些问题,评论区也有说到。 问题一:多轮对话时, 有些代词在回答的答案中, 只将的用户的问题当作上下文, 有时拼写不出完整的问题. 问题二:query改写节点不能开记忆,把之前对话合并成文本放进user prompt,再把温度降低,增加额外规则限制。会好一点。 问题三:用户输入和前文不相干,比如问完保险问其他话题(闲聊),这种情况如何分开做query改写防止污染?还想问下这样改写耗时会不会很久?小模型效果好吗? 这些老师提到的问题其实都是同一个,如何确保问题改写节点,准确理解用户的问题,不要改写错误。此外还有: 多轮对话时,如果A任务没有成,但是词槽或者说参数收集了一半,用户问多轮任务B,接这问C,这样大概率会造成信息丢失。 FAQ/转人工等相关场景没有处理。 如何实现长期记忆。 这些问题,我们依次来尝试解决一下,下面的整体思路,是结合了bert时代的状态机管理(或者说...

生产级写提示词的一些小的tips

1、提示词正常来说有两种方式:一种是结合xml格式,例如:这是一份客服质检数据 一种是markdown结构,例如:## 背景 这是一份客服质检数据。 很多人有习惯让AI来帮我们写提示词,我也会这样做。这里有个建议,去掉AI生成的提示词中的大量的**,之类的东西。这些会占用大量的token,浪费钱,这些符号仅仅只是让我们在markdown渲染工具里面看起来更舒服而已,对大模型来说无所谓的。我们用markdown或者xml是为了结构化,而不是复杂化。 2、生产级任务中,可以写一些示例,我们知道,大模型是非常擅长模仿的,但更适合用在你期望输出结果相对稳定、格式明确的情况。示例要结合各种情况进行应用。比如,你在每天的固定时间,系统要去固定查询一些数据,然后帮你生成一个邮件(html)。这种情况你期望的是一个极其相似的结果。那你就可以给个html模板或者html邮件示例。当然html示例可能会很长,这个时候就别让模型生成了,写一个脚本,在这个节点接收模型产生的数据,直接将数据由脚本渲染为html(可以让AI来写,但是要调试)。 当然,或者是,编写产品需求说明文档(PRD),每个公司肯定...

我只是想留住一个投资人的思考,结果学会了如何让 AI 替我干脏活

我非常喜欢一位投资人的投资风格和分享的投资理念,老粉如果注意过的话,我之前其实提到过一次。最近他不在微博说话了,因为被迫要收取投顾费,所以他转到了且慢基金社区的同路人小组去发言。 我就想着记录下他的投资理念,方便未来哪天,大佬身退了,我也能学个5成的水平。 在开始正文之前,我想要警告各位: 本文不需要太高的技术水平,如果有兴趣,应该可以在几个小时到一天内复现。 我们不会的,AI会的,让他教我们。 使用国内版本的Trae,可以完成。 另外,本文不构成任何投资建议。 https://www.trae.cn/ 我不会的,AI会所以我就问Gemini: 这里为什么会问Obsidian呢,是因为我最近在将我自己所有的知识体系向这里转移。 很明显,看来我需要写一个网络爬虫才能实现我的诉求了。我真正意识到的问题不是“我不会写代码”,而是“我之前问错了问题”。 我已经自己写过爬取静态网页,就是请求一次,所有内容都展示的网页。 但是很明显,且慢的网页不是的,他是动态的,因为有很多内容都需要点击查看全文、查看更多,甚至会跳转到一个新的网页。 所以,我紧接着问了Gemini一个问题: ...